Год назад Google рассказала, что у неё есть специализированное аппаратное решение для машинного обучения собственной разработки. Устройство назвали Tensor Processing Unit (TPU). На момент «анонса» Google уже около года использовала TPU в своих центрах обработки данных.

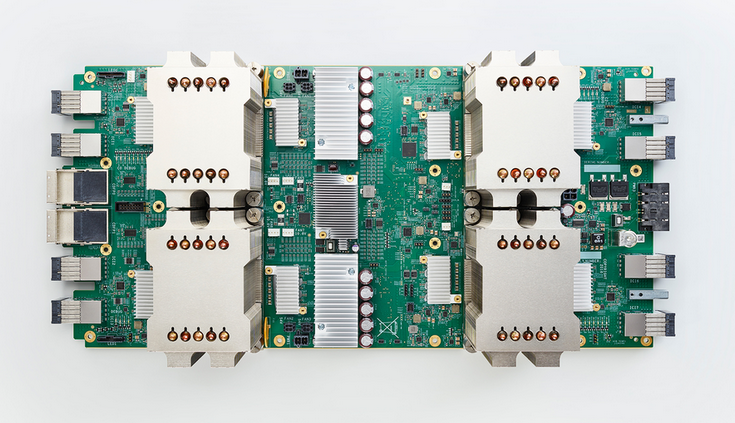

Спустя год поисковый гигант рассказал о TPU второго поколения. И если в прошлый раз нам не раскрыли каких-то подробностей, то теперь известно, что производительность новой системы в задачах машинного обучения достигает 180 TFLOPS! Для сравнения, монструозный GPU GV100 поколения Volta в таких задачах демонстрирует «лишь» 120 TFLOPS. Однако, судя по всему, речь о платформе, содержащей четыре ASIC. При этом Google использует специальные модули TPU, каждый из которых содержит 64 устройства. В общей сложности это даёт производительность на уровне 11,5 PFLOPS.

Благодаря этому, время, необходимо на обучение некоторых систем искусственного интеллекта, сокращается от нескольких недель, до дней или даже часов.

Параллельно с рассказом о новом поколении TPU, Google отметила, что запускает инициативу TensorFlow Research Cloud, в рамках которой ведущим исследовательским институтам и учёным дадут бесплатный доступ к системам на основе TPU второго поколения. Правда, в обмен на доступ к исследованиям и разрешение на использование данных, полученных в рамках этих исследований.

На данный момент TPU активно используются для работы различных сервисов Google, включая поисковик. Но компания призналась, что пока ещё не может отказаться от систем на основе CPU и GPU.

Источник:

Google

Читайте также

Последние новости